Pfadintegrale: Die Mathematik hinter den LHC-Experimenten

Sie passt auf eine Kaffeetasse: die Formel, die alle erdenklichen Vorgänge im Mikrokosmos beschreiben soll. Dabei handelt es sich um das Standardmodell der Teilchenphysik; eine Gleichung, die nur fünf Summanden umfasst. Sie aufzuschreiben gestaltet sich recht einfach – doch sie zu lösen, steht auf einem ganz anderen Blatt. Fachleute aus der Mathematik und der Physik arbeiten seit Jahrzehnten gemeinsam daran, der Formel konkrete Ergebnisse zu entlocken.

Ohne diese lässt sich nämlich nicht prüfen, ob das Standardmodell der Teilchenphysik unsere Welt richtig beschreibt. Indem man die theoretischen Vorhersagen mit experimentellen Messungen vergleicht, lässt sich das Modell testen. Das erfordert aufwändige Versuche, wie sie unter anderem am Large Hadron Collider (LHC) am CERN bei Genf durchgeführt werden. Abweichungen zwischen Theorie und Experiment könnten auf neue, noch nicht bekannte physikalische Gesetzmäßigkeiten hinweisen.

Um allerdings von der einfach anmutenden Formel auf der Kaffeetasse auf eine konkrete Vorhersage für einen Laborversuch zu schließen, bedarf es vieler mathematischer Tricks. Denn in den Gleichungen lauern verschiedene Unendlichkeiten, die erst gezähmt werden müssen. Zudem liefern die Experimente inzwischen präzise Resultate, mit denen die theoretischen Berechnungen Schritt halten müssen: Physiker brauchen immer genauere Kalkulationen.

In den letzten Jahren ist es mit Hilfe verschiedener Ansätze gelungen, dem Standardmodell der Teilchenphysik Geheimnisse zu entlocken, etwa unter Zuhilfenahme zusätzlicher Dimensionen, ausgedachter Spiele und seltsamer Kurven. Das Erstaunliche: Die neuen Techniken helfen nicht nur bei der Beschreibung des ganz Kleinen, sondern auch des ganz Großen – die mathematischen Methoden lassen sich auf die Gravitationswellenphysik anwenden.

Aufeinanderprallende Teilchen

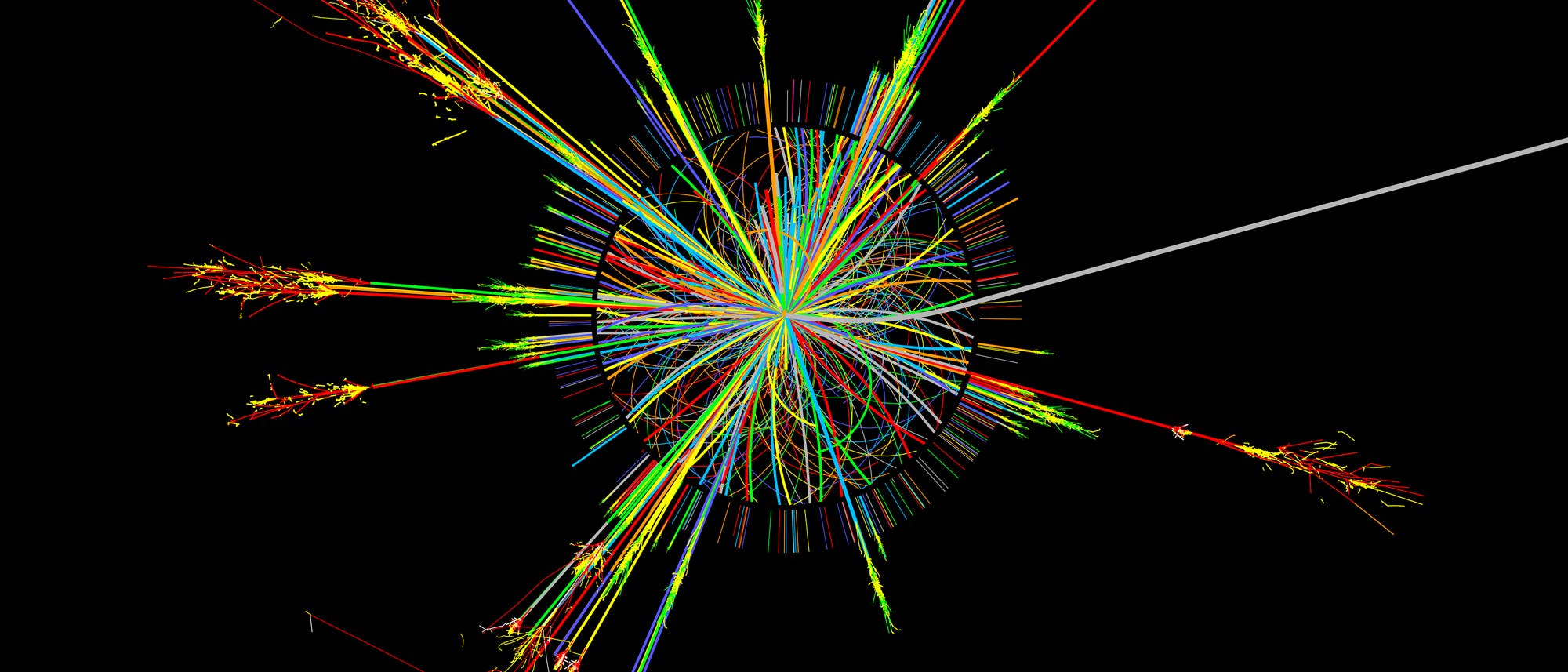

Das Standardmodell wird mit Hilfe von Teilchenbeschleunigern überprüft. Dort prallen extrem stark beschleunigte Teilchen, zum Beispiel Protonen, wie zwei aufeinander zurasende Züge zusammen. Durch den Zusammenstoß werden so große Mengen an Energie frei, dass völlig neue, teilweise kurzlebige Partikel entstehen können. Um diese beziehungsweise deren Zerfallsprodukte zu erfassen, sind um den Kollisionspunkt herum Detektoren angebracht.

Diese Messgeräte bestehen aus einzelnen Segmenten, die jeweils auf eine bestimmte Teilchenart ansprechen und einen kleinen Raumwinkelbereich abdecken. Tritt ein Objekt in diese Region ein, zeichnet der Detektor die Energie des Teilchens auf. Auf die Weise lässt sich nachvollziehen, was während eines Experiments vor sich ging.

Allerdings sind die Ergebnisse mit Ungewissheiten behaftet. Zum Beispiel spricht ein Detektor nur auf Teilchen mit einer Mindestenergie an – wie ein Windrad, das sich erst ab einer bestimmten Windstärke zu drehen beginnt. Auch kann ein Messgerät nicht unterscheiden, ob die Energie von einem einzelnen oder mehreren gleichzeitig auftretenden Partikeln stammt. Tatsächlich sind solche Ereignisse nicht selten: In typischen LHC-Experimenten entstehen »Teilchenjets«, bei denen bis zu 100 Teilchen parallel zueinander in eine Richtung fliegen.

Was passiert während einer Kollision?

Am LHC werden Protonen mit fast Lichtgeschwindigkeit aufeinandergeschossen. Bei so hohen Energien sind es nicht die Protonen selbst, die miteinander wechselwirken, sondern die Elementarteilchen, aus denen sie bestehen: Quarks und Gluonen. Zum Beispiel können zwei Gluonen, die jeweils aus einem Proton stammen, zusammen ein Quark und ein Antiquark (das dazugehörige Antiteilchen) hervorrufen.

Die erzeugten Teilchen fliegen dann radial nach außen, strahlen dabei weitere Elementarteilchen ab und verlieren so Energie. Die ausgesandten Partikel bewegen sich vorwiegend in dieselbe Richtung wie das ursprüngliche Teilchen, wodurch ein Jet entsteht. Haben sie genügend Energie verloren, bilden sie zusammengesetzte Teilchen, so genannte Hadronen (zu denen unter anderem Protonen gehören), die schließlich vom Detektor als Jet aufgezeichnet werden.

Auch 75 Jahre nach Einführung von Quantenfeldtheorien ist keine Methode bekannt, um Streuamplituden exakt zu berechnen

Um das Standardmodell der Teilchenphysik zu prüfen, kann man zum Beispiel berechnen, wie wahrscheinlich es ist, Signale mit zwei unterschiedlichen Jets (so genannte 2-Jet-Ereignisse) zu beobachten – und das dann mit den experimentellen Daten vergleichen.

Beschleunigerphysik auf dem Papier

Zur Berechnung der Wahrscheinlichkeit für ein 2-Jet-Ereignis sind mehrere Schritte nötig. Da bei hohen Energien die Bestandteile der Protonen miteinander wechselwirken, muss man zunächst herausfinden, mit welcher Chance man bei einer bestimmten Beschleunigerenergie ein Elementarteilchen wie ein Quark oder ein Gluon in einem Proton findet, das einen gewissen Impulsanteil trägt. Diese Werte sind aus anderen Experimenten bekannt, wie den HERA-Versuchen am Deutschen Elektronen-Synchrotron in Hamburg. Der wichtigste Baustein der Berechnung ist das Betragsquadrat der »Streuamplitude«: Es enthält die Wahrscheinlichkeiten für alle möglichen Ereignisse, die während der Streuung eintreten können.

Doch auch 75 Jahre nach der Einführung von Quantenfeldtheorien, mit denen sich Elementarteilchen beschreiben lassen, ist keine Methode bekannt, um Streuamplituden exakt zu kalkulieren. Daher ist man auf Näherungen angewiesen. Einen weit verbreiteten Ansatz bietet die Störungstheorie.

Anstatt einen komplizierten mathematischen Term wie die Streuamplitude zu berechnen, nähert man sich ihr durch eine unendlich lange Summe an, wobei jeder Summand von einem Parameter g angeführt wird, der immer höhere Potenzen enthält. Falls der Parameter also klein ist, schrumpfen die Terme nach und nach. Je mehr Summanden man in der Rechnung einbezieht, so die Theorie, desto präziser sollte das Ergebnis werden.

\[A + g^2\cdot B + g^4\cdot C + g^6\cdot D + …\]Der Parameter g entspricht meist der Kopplung, das ist die Stärke der Wechselwirkung zwischen den Teilchen. Bei Hochenergieexperimenten, wie sie in Teilchenbeschleunigern stattfinden, ist der Wert tatsächlich sehr klein.

Allerdings ist die störungstheoretische Näherung einer Streuung meist eine asymptotische Reihe – das bedeutet, die Summanden schrumpfen nur bis zu einem gewissen Punkt. Die Summanden, die mit dem kleinen Parameter multipliziert werden, wachsen an und werden irgendwann so groß, dass der Parameter sie nicht mehr dämpfen kann. Das heißt: Bis zu einer bestimmten Stelle wird die Berechnung genauer, je mehr Terme man hinzuzieht. Doch irgendwann ist es umgekehrt, und die Berücksichtigung weiterer Summanden führt zu einem schlechteren Ergebnis.

Von diesem Punkt sind wir in der Realität aber noch weit entfernt. Selbst wenn die Störungstheorie eine Näherung darstellt, ist die Berechnung der einzelnen Terme der – theoretisch unendlich langen – Summe extrem schwierig. Bisher ist es nur möglich, die ersten paar Summanden zu bestimmen. Und auch das stellt sich als sehr kompliziert heraus.

Von der Kaffeetasse zu Feynman-Diagrammen

Im Standardmodell wird die Welt durch Felder beschrieben. Demnach durchziehen Quantenfelder unsere gesamte Raumzeit. Anregungen in diesen Feldern, die man sich als Wellen vorstellen kann, entsprechen den Elementarteilchen und den zwischen ihnen wirkenden Kräften. Auf der Kaffeetasse bezeichnet beispielsweise ψ das Feld eines Fermions (eine Teilchenklasse, zu der Elektronen und Quarks gehören), während sich alle Kräfte vermittelnden Teilchen wie Gluonen und Photonen hinter Fμν verbergen.

Um von der Formel auf der Tasse zu den Koeffizienten in der Störungsreihe zu schließen, greifen Fachleute auf Zeichnungen zurück, die als Feynman-Diagramme bekannt sind. Dabei gehen sie folgendermaßen vor: Zuerst pickt man aus der Gleichung alle Terme heraus, die genau zwei Felder enthalten. Diese stellt man durch eine Linie dar, die beschreibt, wie sich ein Teilchen ungestört von A nach B bewegt. Um verschiedene Teilchen voneinander zu unterscheiden, verwendet man beispielsweise eine gerade Linie mit einem Pfeil für Fermionen (wie Quarks oder Elektronen) und eine gewellte für Gluonen oder Photonen.

Als Nächstes wendet man sich Termen mit drei oder mehr Feldern zu. Diese definieren Punkte, so genannte Vertices, an denen die entsprechenden Teilchen miteinander wechselwirken. Jeder Vertex kommt mit einer Potenz der Kopplung g: Vertices aus drei Linien sind proportional zu g, Vertices aus vier proportional zu g2, und so weiter. Je mehr Linien (und damit Teilchen) involviert sind, desto höher die Potenz von g. Da g bei Experimenten in Teilchenbeschleunigern klein ist, führt eine höhere Potenz zu kleineren Zahlenwerten – somit ist die Wahrscheinlichkeit für solche Ereignisse gering.

Davon ausgehend lassen sich alle möglichen Feynman-Diagramme zeichnen, die zu einem Laborversuch passen, zum Beispiel von zwei aneinandergestreuten Gluonen, die am Ende in andere Teilchen zerfallen sind. Die einlaufenden Linien in den Diagrammen stellen dann die Gluonen dar; die auslaufenden repräsentieren jene Partikel, die Ausgangspunkt der experimentell gemessenen Teilchenjets sind. Das heißt, Fachleute zeichnen etliche Diagramme, die den möglichen Ereignissen entsprechen, die während eines Experiments stattgefunden haben könnten.

Anschließend übersetzen Forschende die Feynman-Diagramme in eine mathematische Formel. Um die gesuchte Streuamplitude zu berechnen, muss man alle möglichen Feynman-Diagramme für einen Streuprozess summieren. Die dazugehörigen Terme lassen sich anhand der Potenzen von g ordnen: Zunächst betrachtet man niedrige Potenzen und arbeitet sich dann zu höheren vor. So erhält man die störungstheoretische Summe für die Streuamplitude.

Ein Diagramm lässt sich Baustein für Baustein übersetzen. Für jede Linie und jeden Vertex gibt es eine klare mathematische Übereinstimmung und Regeln. An Vertices gilt beispielsweise immer die Impulserhaltung: Die Summe der einlaufenden Impulse ist gleich der Summe der auslaufenden. Sind die äußeren Impulse vorgegeben, so ist auch der Impulsfluss durch innere Linien festgelegt, sofern das Diagramm keine Schleife enthält (siehe erste Zeile in Abbildung [Feynman-Störung]). Solche Diagramme bezeichnet man als Baumdiagramme, sie entsprechen der führenden Ordnung in der Störungsentwicklung.

Die Berechnung der Baumdiagramme ist – zumindest aus mathematischer Sicht – kein Problem. Doch für Streuamplituden mit vielen ausgehenden Teilchen n (so genannte 2→n-Prozesse) wächst die Anzahl der zu betrachtenden Baumdiagramme mit n stark an. Eine Summierung wird somit praktisch unmöglich.

Allerdings gibt es Methoden, um das Problem zu umgehen. Ein Beispiel dafür ist ein 1988 von den Physikern Frits Berends und Walter Giele von der Universität Leiden entwickelter Algorithmus, der eine effiziente Berechnung der Baumdiagramme für 2→n-Prozesse erlaubt. Die Rechendauer steigt dabei nur polynomiell (und nicht exponentiell) mit der Anzahl der ausgehenden Teilchen n an.

Schleifendiagramme führen zu Schwierigkeiten

Für präzise Berechnungen muss man allerdings auch die nächsten Ordnungen der Störungsreihe jenseits der Baumdiagramme berücksichtigen. Hierbei stößt man schnell auf Probleme: Zwar sind die äußeren Impulse wie zuvor vorgegeben, der Impulsfluss durch die inneren Linien ist jedoch nicht festgelegt. In der zweiten Zeile von [Feynman-Störung] muss man zum Beispiel den Impulsfluss durch eine innere Linie vorgeben, um alle übrigen Impulse eindeutig zu bestimmen. In der dritten Zeile sind sogar zwei interne Impulse frei wählbar.

Das Problem: Einige der Feynman-Integrale liefern unendliche Werte

Hier findet nun eine weitere Feynman-Regel Anwendung: Man muss über die unbestimmten inneren Impulse integrieren – damit berücksichtigt man jeden möglichen Wert, den sie annehmen könnten. Diagramme mit einem frei wählbaren Impuls werden als Einschleifendiagramme bezeichnet (sie enthalten tatsächlich eine Schleife), während solche mit zwei freien Impulsen Zweischleifendiagramme heißen (sie weisen entsprechend zwei Schleifen auf).

Das Problem: Einige der Feynman-Integrale liefern unendliche Werte. Diese »Divergenzen« werden entweder ultraviolett genannt (falls der Impuls eines Teilchens gegen unendlich geht) oder infrarot (falls ein Teilchen eine extrem kleine Energie besitzt, die gegen null strebt).

Um diesen auftretenden Unendlichkeiten zu entgehen, gibt es mathematische Tricks. Als einfachste Methode hat sich erwiesen, die Dimensionen der Raumzeit zu variieren. Das ist die »dimensionale Regularisierung«. Hierbei rechnet man nicht in vier Raumzeit-Dimensionen, sondern zunächst ganz allgemein in D Dimensionen. Am Ende der Kalkulationen betrachtet man dann den Grenzfall D → 4. Im Allgemeinen erscheinen die ursprünglichen Unendlichkeiten durch diesen Trick als Terme der Form 1⁄D−4 im Ergebnis.

Unendlichkeiten beseitigen

Als Nächstes gilt es, diese Terme loszuwerden. Denn wenn man für D = 4 einsetzt, hat man einen Term, in dem durch null geteilt wird. Falls die Divergenzen ultravioletter Natur sind, kann man auf eine so genannte Renormierung zurückgreifen. Dabei werden die Unendlichkeiten in Renormierungskonstanten absorbiert. Als einfache Analogie kann ein Wochenmarkt in einem Land mit Hyperinflation dienen: Der Preis für die Lebensmittel steigt zwar weiter an – am Ende bekommt man aber für einen Sack Äpfel immer die gleiche Menge Kartoffeln. Die Wertunterschiede zwischen den physischen Gegenständen bleiben unverändert, obwohl die Währung ihren Wert verliert. Das ist in der Physik ebenso. Relationen zwischen physikalischen Observablen sind endlich (wie das Verhältnis zwischen Kartoffeln und Äpfeln), auch wenn man in Zwischenschritten auf Unendlichkeiten stößt.

Infrarotdivergenzen lassen sich zwar etwas schwieriger beseitigen, doch die Physiker Tōichirō Kinoshita, Tsung-Dao Lee und Michael Nauenberg haben in den 1960er Jahren bewiesen, dass sich die Unendlichkeiten immer gegenseitig aufheben (sie tauchen mal mit positivem, mal mit negativem Vorzeichen auf).

Zudem muss man sicherstellen, dass sich die Infrarot- und Ultraviolettdivergenzen nicht überlappen. Der Mathematiker Heisuke Hironaka vom Institute for Advanced Study in Princeton hat 1964 bewiesen, dass sie sich immer voneinander lösen lassen. Zur Veranschaulichung der Aufgabe hat Hironaka sein so genanntes Polyederspiel eingeführt.

Hironakas Polyederspiel wird von zwei Spielern A und B gespielt. Sie starten mit einer endlichen Menge M von Punkten mit ganzzahligen, positiven Koordinaten im n-dimensionalen Raum. Würde man um diese Punkte von unten kommend eine unendlich große Plane spannen, hätte die Figur (positive konvexe Hülle genannt) die Form eines Polyeders, das mit Δ bezeichnet wird.

Die Regeln lauten:

- Spieler A wählt eine nicht leere Untermenge S aus {1,..., n}.

- Spieler B wählt ein Element i aus der Untermenge S.

Dann werden alle Punkte m = (m1, ..., mn) aus M durch neue Punkte m' = (m'1, ,..., m'n) wie folgt ersetzt:

m'j = mj, falls j ≠ i,

mi = ∑j ∈ S mj−1

Das heißt die i-te Koordinate wird durch die Summe der Koordinaten aus der Menge S minus eins ersetzt, die anderen Koordinaten ändern sich nicht. Danach geht man zurück zu Spielzug 1.

A hat gewonnen, falls nach einer endlichen Anzahl von Zügen das Polyeder nur von einem Punkt erzeugt wird, wie in der rechten Figur der Abbildung. B hat gewonnen, falls er dies verhindern kann. Hironaka konnte zeigen, dass A immer gewinnen kann.

Die Gewinnstrategie entspricht einem Algorithmus, der Unendlichkeiten in Feynman-Integralen auflöst, wobei n die Anzahl der inneren Linien des Schleifendiagramms ist. Die Abbildung zeigt eine Möglichkeit von Zügen für n = 2. Für diesen Fall ist die Lösung recht simpel: Spieler A wählt einfach immer S={1, 2}. Für n > 2 ist das Polyederspiel allerdings deutlich komplizierter – probieren Sie es aus.

Ein Problem in ein einfacheres umwandeln

Um den Wert der regularisierten Feynman-Integrale konkret zu bestimmen, haben die Physiker Thomas Binoth vom Laboratoire de Physique Théorique in Annecy und Gudrun Heinrich von der Université Paris-Sud in Orsay im Jahr 2000 eine computergestützte Methode entwickelt. Da ihr Ansatz jedoch extrem viel Rechenzeit erfordert, greift man vor allem bei komplizierten Feynman-Integralen darauf zurück, die sich (noch) nicht analytisch berechnen lassen.

Sofern möglich versuchen Fachleute, die Integrale exakt auszuwerten. Häufig verwenden sie dabei eine 1991 vom Physiker Anatoly Kotikov vom Bogolyubov Institute for Theoretical Physics in Kiew vorgeschlagene Methode, bei der man eine Differenzialgleichung für die zu berechnenden Feynman-Integrale aufstellt.

Hierzu betrachtete Kotikov eine Familie von Feynman-Integralen, die sich ergeben, wenn man dem ursprünglichen Diagramm Zweier-Vertices hinzufügt und innere Linien zusammenzieht. Dadurch entstehen unendlich viele neue Integrale. Die Physiker Konstantin Chetyrkin und Fyodor Tkachov vom Institute for Nuclear Research in Moskau haben bereits 1981 gezeigt, dass diese miteinander zusammenhängen: Jedes Familienmitglied lässt sich als Linearkombination endlich vieler anderer Integrale – so genannte Master-Integrale – schreiben.

Der Physiker Stefano Laporta von der Universität Bologna hat im Jahr 2000 einen Algorithmus konstruiert, der diese Entwicklung in Master-Integrale effizient berechnet. Da auch die Ableitungen der Feynman-Integrale nach den Impulsen und Massen Mitglieder der Integralfamilie sind, erhält man ein System von Differenzialgleichungen. Damit wird das Problem, ein Feynman-Integral zu berechnen, auf die Aufgabe heruntergebrochen, ein endliches System von Differenzialgleichungen zu lösen. Wie sich herausstellt, lässt sich jedes Feynman-Integral auf diese Weise vereinfachen.

An dieser Stelle kann man wieder auf Computer zurückgreifen, um die Resultate konkret zu berechnen. Die Physiker Zhi-Feng Liu und Yan-Qing Ma von der Universität Peking haben 2022 in einer Arbeit erklärt, wie sich die Differenzialgleichung numerisch lösen lässt.

Berechnungen mit Stift und Papier

Aber auch auf der analytischen Seite gibt es Fortschritte: Der Physiker Johannes Henn vom Institute for Advanced Study in Princeton hat 2013 gezeigt, dass sich das System von Differenzialgleichungen oft so transformieren lässt, dass sie nur durch einen einzigen Vorfaktor (D−4) von der Raumzeit-Dimension abhängen. Gelingt das, lassen sich die Differenzialgleichungen leicht lösen. Das reduziert das Problem, das Feynman-Integral exakt zu berechnen, darauf, eine entsprechende Transformation zu finden. Ob das immer möglich ist, ist allerdings noch unklar.

Um Feynman-Integrale mit Stift und Papier zu kalkulieren, arbeiten Mathematiker und Physiker Hand in Hand. Da sich jedes Mitglied einer Familie von Feynman-Integralen als Kombination endlich vieler Master-Integrale darstellen lässt, spannt die Familie aus mathematischer Sicht einen endlich-dimensionalen Vektorraum auf.

Diese algebraische Sichtweise lässt sich auf die Integranden übertragen. Die Physiker Pierpaolo Mastrolia von der Universität Padua und Sebastian Mizera vom Perimeter Institute for Theoretical Physics in Waterloo (Kanada) haben 2019 gezeigt, dass der Vektorraum ein Skalarprodukt besitzt: Ebenso wie man zwei Vektoren in der Ebene miteinander multiplizieren kann, ist das auch mit den Feynman-Integralen machbar. Damit lassen sich unter anderem die Koeffizienten direkt berechnen, die in der Entwicklung in Master-Integrale auftreten.

Eine Verknüpfung zur Geometrie

Wie sich herausstellt, gibt es eine Verbindung zwischen den Feynman-Integralen und dem Gebiet der algebraischen Geometrie: Die Funktionen, die sich ergeben, sobald man ein Integral berechnet hat, hängen mit geometrischen Formen zusammen.

Die meisten bisher berechneten Feynman-Integrale sind mit einer Kugeloberfläche verbunden

Die meisten bisher betrachteten Feynman-Integrale sind mit algebraischen Kurven assoziiert. Dabei handelt es sich um Kurven, die durch Polynomgleichungen definiert sind, wie man sie aus der Schule kennt. Allerdings setzt man für sie nicht reelle, sondern komplexe Zahlen ein, die außerdem Wurzeln aus negativen Werten enthalten. Da sich komplexe Zahlen als zweidimensionale Zahlenpaare darstellen lassen (mit einem Real- und einem Imaginärteil) wird somit aus der ursprünglich eindimensionalen Kurve eine Oberfläche. Die überwiegende Zahl der berechneten Feynman-Integrale ist mit einer Kugeloberfläche verbunden, also einer Fläche ohne Löcher. Die Lösungen dieser Integrale entsprechen Verallgemeinerungen der Logarithmusfunktion, so genannten multiplen Polylogarithmen.

Allerdings lassen sich nicht alle Feynman-Integrale durch multiple Polylogarithmen ausdrücken. Beginnend mit Zweischleifenintegralen tauchen Funktionen auf, zu denen kompliziertere Geometrien gehören: Die Oberflächen können nun auch Löcher haben. Ein Beispiel dafür sind elliptische Kurven, die einem Donut ähneln. Je weiter man in den Ordnungen der Feynman-Diagramme fortschreitet, desto komplexer werden die Geometrien der dazugehörigen Formen, die teilweise viele Dimensionen erfordern – und sich nicht mehr als algebraische Kurve darstellen lassen.

Beispiele für solche hochdimensionalen Verallgemeinerungen von algebraischen Kurven sind Calabi-Yau-Mannigfaltigkeiten. In der eindimensionalen Form entspricht solch eine Mannigfaltigkeit einer elliptischen Kurve, in zwei Dimensionen bezeichnet man sie als K3-Flächen, und dreidimensionale Calabi-Yau-Mannigfaltigkeiten treten in einem anderen Zusammenhang in der Stringtheorie auf.

Die Techniken lassen sich auch auf Gravitationswellen übertragen, also die Physik bei größten Abständen

Die gegenwärtige Forschung umfasst sowohl Feynman-Integrale, die mit algebraischen Kurven mit zwei oder mehr Löchern zusammenhängen, als auch solche mit Calabi-Yau-Mannigfaltigkeiten der Dimension zwei oder höher. Beide Fälle spielen eine wichtige Rolle für Präzisionsrechnungen in der Elementarteilchenphysik.

Interessanterweise lassen sich die Techniken auf Gravitationswellen übertragen, also die Physik bei größten Abständen. Gravitationswellen entstehen beim Verschmelzen kompakter, massereicher Objekte wie Schwarzen Löchern, Neutronensternen oder Weißen Zwergen. Kurz bevor die Giganten kollidieren, umkreisen sie sich gegenseitig sehr eng. Diese Phase lässt sich mittels Störungstheorie beschreiben, wobei die hier erläuterten Techniken zum Einsatz kommen.

Im Unterschied zur Physik kleinster Teilchen ist die Gravitationswellenphysik jedoch eine klassische Theorie. Quanteneffekte können also vernachlässigt werden. In der Endphase des Verschmelzungsprozesses wächst die Wechselwirkung zwischen den sich umkreisenden Objekten so stark an, dass die Störungstheorie nicht mehr anwendbar ist. Für diese Phase greifen Fachleute auf Computer zurück. Das erfordert allerdings viel Rechenzeit – daher ist es wichtig, die Anfangsphase möglichst präzise zu beschreiben, um den Aufwand zu reduzieren. Hierbei hilft ein gutes Verständnis der Berechnung von Feynman-Integralen auf kleinsten Skalen – auch wenn beide Bereiche auf den ersten Blick sehr unterschiedlich wirken.

Schreiben Sie uns!